问题描述:

Nginx 服务器大量499报错

问题分析:

1 499出现的原因

google定义:

499 / ClientClosed Request

An Nginx HTTP server extension. This codeis introduced to log the case when the connection is closed by client whileHTTP server is processing its request, making server unable to send the HTTP header back

维基百科定义:

499Client Closed Request (Nginx)

Used in Nginx logs to indicate when the connection has been closed by client while the server is still processing itsrequest, making server unable to send a status code back

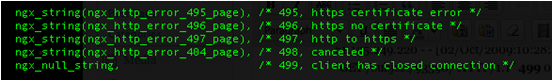

Nginx源码:

grep一下nginx源码,定义在ngx_request_t.h :

这是nginx定义的一个状态码,用于表示这样的错误:服务器返回http头之前,客户端就提前关闭了http连接

继续grep :

这很有可能是因为服务器端处理的时间过长,客户端“不耐烦”了。

要解决此问题,就需要在程序上面做些优化了。

再grep下“NGX_HTTP_CLIENT_CLOSED_REQUEST”,发现目前这个状态值只在ngx_upstream中赋值

upstream在以下几种情况下会返回499:

如上代码,当连接错误时会返回499。

(2)server处理请求未结束,而client提前关闭了连接,此时也会返回499。

(3)在一个upstream出错,执行next_upstream时也会判断连接是否可用,不可用则返回499。

总之,这个错误的比例升高可能表明服务器upstream处理过慢,导致用户提前关闭连接。而正常情况下有一个小比例是正常的。

继续分析:

问题的核心就是要排查为什么服务端处理时间过长

可能问题:

1 后台python程序处理请求时间过长

2 mysql慢查询

通过查看监控:

1 cpu和内存的使用,都在正常范围

2 后台程序访问正常

3 MySQL没有慢查询

结果:

经过询问老大后得知,这个nginx为查询违章的api,用户提交查询后, python就去数据库或者交通局的网站查询。这个查询会有消耗一定的时间,所以,用户会主动断开连接

解决问题:

proxy_ignore_client_abort on; #让代理服务端不要主动关闭客户端的连接。

默认 proxy_ignore_client_abort 是关闭的,此时在请求过程中如果客户端端主动关闭请求或者客户端网络断掉,那么 Nginx 会记录 499,同时 request_time 是「后端已经处理」的时间,而upstream_response_time 为“-“ (已验证)。

如果使用了 proxy_ignore_client_abort on ;

那么客户端主动断掉连接之后,Nginx 会等待后端处理完(或者超时),然后记录「后端的返回信息」到日志。所以,如果后端返回 200,就记录 200 ;如果后端放回 5XX ,那么就记录 5XX 。

如果超时(默认60s,可以用 proxy_read_timeout 设置),Nginx 会主动断开连接,记录 504

注:只在做反向代理的时候加入,作为其他服务器的时候,关闭为好,默认设置是关闭的!